Лекция 7 Обратимость матриц. Псевдообратная матрица. МНК в матричной форме#

Обратная матрица: определение, существование и единственность#

Рассмотрим проблему определения операции, обратной умножению матриц.

Пусть A — квадратная матрица порядка n. Матрица A^{-1} , удовлетворяющая вместе с заданной матрицей A равенствам:

называется обратной. Матрицу A называют обратимой, если для неё существует обратная, в противном случае — необратимой.

Из определения следует, что если обратная матрица A^{-1} существует, то она квадратная того же порядка, что и A. Однако не для всякой квадратной матрицы существует обратная. Если определитель матрицы A равен нулю:

то для неё не существует обратной. В самом деле, применяя теорему об определителе произведения матриц к единичной матрице E = A^{-1} A , получаем противоречие:

тогда как \det E = 1 . Следовательно, отличие определителя квадратной матрицы от нуля является единственным условием существования обратной матрицы. Напомним, что квадратную матрицу, определитель которой равен нулю, называют вырожденной (особой), в противном случае — невырожденной (неособой).

Теорема о существовании и единственности обратной матрицы#

Квадратная матрица

определитель которой отличен от нуля, имеет обратную матрицу и притом только одну:

где A^{+} — матрица, транспонированная к матрице, составленной из алгебраических дополнений элементов A.

Матрица A^{+} называется присоединённой матрицей по отношению к A.

Матрица \frac{1}{\det A} A^{+} существует при условии \det A \ne 0 . Нужно показать, что она обратна к A, то есть удовлетворяет двум условиям:

Докажем первое равенство. Согласно замечанию 2.3, из свойств определителя следует, что:

Следовательно:

Аналогично доказывается второе равенство.

Итак, при \det A \ne 0 матрица A имеет обратную:

Единственность: допустим, существует ещё одна обратная матрица B (где B \ne A^{-1} ), такая что:

Умножим обе части этого равенства слева на A^{-1} :

что противоречит B \ne A^{-1} . Значит, обратная матрица единственна.

Замечания

-

Из определения следует, что матрицы

Aи A^{-1} перестановочны. -

Обратная к невырожденной диагональной матрице — тоже диагональная:

-

Обратная к невырожденной нижней (или верхней) треугольной матрице — тоже нижняя (или верхняя) треугольная.

-

Элементарные матрицы имеют обратные, которые также являются элементарными.

Свойства обратной матрицы#

Операция обращения матрицы обладает следующими свойствами:

где все указанные операции имеют смысл (матрицы квадратные и невырожденные).

Доказательство свойства 2#

Если произведение двух квадратных невырожденных матриц A и B определено, то обратная к произведению матрица равна:

Доказательство:

Определитель произведения матриц:

а значит, \det(AB) \ne 0 , если \det A \ne 0 и \det B \ne 0 , то есть матрица AB также невырожденная и имеет обратную.

Проверим по определению, что B^{-1} A^{-1} является обратной по отношению к AB :

Так как обратная матрица существует и единственна, получаем:

Свойство доказано.

Остальные свойства можно доказать аналогично.

Замечания

- Для комплексной матрицы справедливо равенство, аналогичное свойству 3:

где символ \ast обозначает сопряжённую (эрмитову) матрицу.

- Операция обращения позволяет определить целую отрицательную степень невырожденной матрицы

A. Для любого натурального числаn:

Способы нахождения обратной матрицы#

Пусть дана квадратная матрица A. Требуется найти обратную матрицу A^{-1} .

Первый способ — через присоединённую матрицу#

Описан в теореме 4.1 (о существовании и единственности обратной матрицы):

-

Вычислить определитель \det A .

Если \det A = 0 , то обратной матрицы не существует (матрица вырожденная). -

Составить матрицу из алгебраических дополнений A_{ij} = (-1)^{i+j} M_{ij} , где M_{ij} — минор элемента a_{ij} . Обозначим:

- Транспонировать эту матрицу:

Получим присоединённую матрицу:

- Разделить все элементы присоединённой матрицы на \det A :

Второй способ — метод элементарных преобразований#

-

Составить блочную матрицу (A \mid E) , приписав к

Aединичную матрицуEтого же порядка. -

С помощью элементарных преобразований строк привести левый блок

Aк простейшему виду \Lambda .

При этом:

где S — квадратная матрица, полученная из E.

- Если \Lambda = E , то S = A^{-1} .

Если \Lambda \ne E , то обратной матрицы не существует.

Обоснование:

Преобразования приводят блочную матрицу к виду (\Lambda \mid S) , где выполняется:

Если A невырожденная, то \Lambda = E , и, следовательно, SA = E \Rightarrow S = A^{-1} .

Если A вырожденная, то \Lambda \ne E , и обратной матрицы не существует.

Замечания#

1. Обратная матрица второго порядка#

Пусть

Обратная матрица находится по следующему правилу:

а) Поменять местами элементы главной диагонали

б) Изменить знаки у элементов побочной диагонали

в) Разделить полученную матрицу на определитель \det A = ad - bc

В результате:

Пояснение:

2. Альтернативная реализация второго способа (по столбцам)#

- Составить блочную матрицу:

- При помощи элементарных преобразований столбцов привести её к виду:

Тогда блок T будет равен:

Матричные уравнения#

Рассмотрим матричное уравнение вида

где A и B — данные матрицы, имеющие одинаковое количество строк, причем матрица A квадратная. Требуется найти матрицу X , удовлетворяющую уравнению.

О существовании и единственности решения матричного уравнения (4.5):

Если определитель матрицы A отличен от нуля, то матричное уравнение (4.5) имеет единственное решение

В самом деле, подставляя X = A^{-1} B в левую часть (4.5), получаем:

т.е. правую часть уравнения.

Заметим, что решением уравнения A X = E является обратная матрица: X = A^{-1} .

Рассмотрим также уравнение вида

где A и B — данные матрицы, имеющие одинаковое количество столбцов, и A — квадратная.

Теорема О существовании и единственности решения уравнения#

Если \det A \ne 0 , то имеет единственное решение

Заметим:

- В уравнении матрица X умножается на A слева — это "левое частное".

- В уравнении матрица Y умножается на A справа — это "правое частное".

Пример#

Даны матрицы:

Обратная матрица:

а) Решить AX = B

б) Уравнение YB = B

Решений нет, так как количество столбцов у B — 3, а у A — 2. Размеры не согласованы.

в) Решить YA = C

Пример#

Решить уравнение:

Решение.

Преобразуем:

где

Псевдообратная матрица#

Обратная матрица в отличие от полуобратной имеет в силу определения очевидные свойства:

так как единичная матрица E=AA^{-1}=A^{-1}A , разумеется, эрмитова. В определении полуобратной матрицы имеется некоторый произвол (см. п.3 замечаний 4.6), которым можно воспользоваться так, чтобы полуобратная матрица обладала аналогичными свойствами.

Пусть A — произвольная матрица размеров m\times n . Полуобратная матрица A^{\sim1} размеров n\times m называется псевдообратной для матрицы A , если матрицы AA^{\sim1} и A^{\sim1}A эрмитовы, т.е. псевдообратная матрица A^{\sim1} определяется четырьмя условиями:

Покажем, что псевдообратная матрица A^{\sim1} существует для любой матрицы A . Действительно, если A=O — нулевая матрица размеров m\times n , то A^{\sim1}=O^T — нулевая размеров n\times m , что следует из равенств (4.17).

Пусть матрица A — ненулевая. Тогда матрица A^{\sim1} , удовлетворяющая равенствам (4.17), имеет вид (4.14):

Покажем, что выбором матриц U и V в формуле (4.19) можно получить матрицу, удовлетворяющую условиям (4.18). В самом деле, запишем скелетное разложение (4.10) матрицы A :

Найдем произведение:

Подставим его в первое из равенств (4.18):

Используя свойства операции сопряжения, а также п. 1 замечаний 4.2, получаем:

Умножая обе части равенства на матрицу S слева и на матрицу S^{\ast} справа, приходим к равенству:

Подставим в это равенство матрицу SS^{\ast} , предварительно разбив ее на блоки SS^{\ast}=\begin{pmatrix} S_1\!\!&\vline\!\!&S_2\\ \hline S_3\!\!&\vline\!\!& S_4 \end{pmatrix} квадратными матрицами S_1 и S_4 порядков r и (m-r) и прямоугольными матрицами S_2 и S_2 размеров r\times(m-r) и (m-r)\times r соответственно. Выполняя умножение блочных матриц, получаем:

Равенство полученных блочных матриц обеспечивается условием:

в силу эрмитовости матрицы SS^{\ast} , а \begin{pmatrix}S_4^{-1}\end{pmatrix}^{\ast}= \begin{pmatrix}S_4^{\ast}\end{pmatrix}^{-1} .

Аналогичным образом можно показать, что второе из равенств (4.18) выполняется, если положить:

где T_3,T_4 — блоки размеров (n-r)\times r и (n-r)\times(n-r) матрицы T^{\ast}T=\begin{pmatrix} T_1\!\!&\vline\!\!&T_2\\ \hline T_3\!\!&\vline\!\!& T_4\end{pmatrix} .

Таким образом, для любой матрицы существует псевдообратная матрица и притом только одна.

Замечания 4.7#

-

Если матрица A обратимая, то обратная матрица A^{-1} , как следует из п. 1 замечаний 4.6, совпадает с псевдообратной, т.е. A^{-1}=A^{\sim1} .

-

Из невырожденности матриц S и T следует, что при любом разбиении эрмитовых матриц:

на квадратные блоки S_1,\,S_4,\,T_1,\,T_4 , существуют обратные матрицы S_1^{-1},\,S_4^{-1},\,T_1^{-1},\,T_4^{-1} .

- Имеются другие определения псевдообратной матрицы, равносильные приведенному выше. Например:

- В общем случае произведение псевдообратных матриц некоммутативно (AB)^{\sim1}\ne B^{\sim1}\cdot A^{\sim1} .

Свойства псевдообратной матрицы#

Операция псевдообращения матриц обладает следующими свойствами:

Эти свойства доказываются по определению (4.17), (4.18). Докажем, например, свойство 3 (первое равенство). По определению псевдообратной матрицы имеем:

Следовательно, A=\bigl[(A^{\ast}A)^{\sim1}A^{\ast}\bigr]^{\sim1} . Тогда по свойству 1: A^{\sim1}=(A^{\ast}A)^{\sim1}A^{\ast} .

Способы нахождения псевдообратной матрицы#

Пусть дана ненулевая матрица A размеров m \times n . Требуется найти псевдообратную матрицу A^{\sim 1} .

Первый способ#

Для нахождения псевдообратной матрицы (4.19) нужно выполнить следующие действия:

-

Составить блочную матрицу

приписывая к матрице A слева и снизу единичные матрицы соответствующих размеров. Правый нижний блок этой матрицы может быть произвольным. -

Элементарными преобразованиями над первыми m строками и первыми n столбцами привести блочную матрицу к виду

где \Lambda — матрица простейшего вида (4.8):

где E_r — единичная матрица порядка r ( 1 \leqslant r \leqslant \min\{m,n\} ). -

Найти произведения SS^{\ast} и T^{\ast}T , представив их в виде блочных матриц:

выделяя блоки S_2, S_4 размеров r \times (m-r) , (m-r) \times (m-r) и T_3, T_4 размеров (n-r) \times r , (n-r) \times (n-r) . -

Вычислить матрицы:

-

Получить псевдообратную матрицу:

Замечание 4.8. Если r = m или r = n , в (4.20) будут отсутствовать соответствующие блоки. В частных случаях, когда строки или столбцы матрицы A линейно независимы, псевдообратную матрицу можно найти проще (см. далее частные случаи).

Второй способ#

Используем скелетное разложение (4.10):

1-2. Выполнить первые два пункта первого способа. Получить матрицы S, T и \Lambda , удовлетворяющие условию:

где \Lambda = \begin{pmatrix}E_r\!\!&\vline\!\!&O\\\hline O\!\!&\vline\!\!&O\end{pmatrix} .

-

Найти обратные матрицы S^{-1} и T^{-1} .

-

Записать матрицы:

Матрица B состоит из первых r столбцов S^{-1} , а C — из первых r строк T^{-1} . -

Получить псевдообратную матрицу по формуле:

Доказательство эквивалентности способов:

Имея скелетное разложение A = BC , найдем:

Обращая блочную матрицу SS^{\ast} по формуле Фробениуса:

где M = (S_1 - S_2S_4^{-1}S_3)^{-1} , получаем:

где V = -S_2S_4^{-1} . Аналогично для второго множителя. Таким образом, формулы (4.22) и (4.21) дают одинаковый результат.

Частные случаи нахождения псевдообратной матрицы#

1. Скалярный случай#

Если матрица A = (a_{11}) - число:

2. Диагональная матрица#

Для A = \operatorname{diag}(a_{11}, a_{22}, \ldots, a_{nn}) :

где

3. Линейно независимые столбцы#

Если столбцы A линейно независимы:

4. Линейно независимые строки#

Если строки A линейно независимы:

Пример#

Найти псевдообратные матрицы для:

Решение#

Для матрицы A (диагональная):

Для матрицы B (матрица-строка):

Для матрицы C (линейно независимые столбцы):

Проверка первым способом:

-

Составляем блочную матрицу:

-

Приводим к ступенчатому виду:

Получаем T = E_2 , S = \begin{pmatrix}1&0&0\\-1&1&0\\0&-1&1\end{pmatrix} , r = 2 .

-

Находим:

-

Итоговая псевдообратная матрица:

Результаты обоих методов совпадают.

Метод наименьших квадратов в матричном виде (МНК)#

Представим данные как систему линейных уравнений.

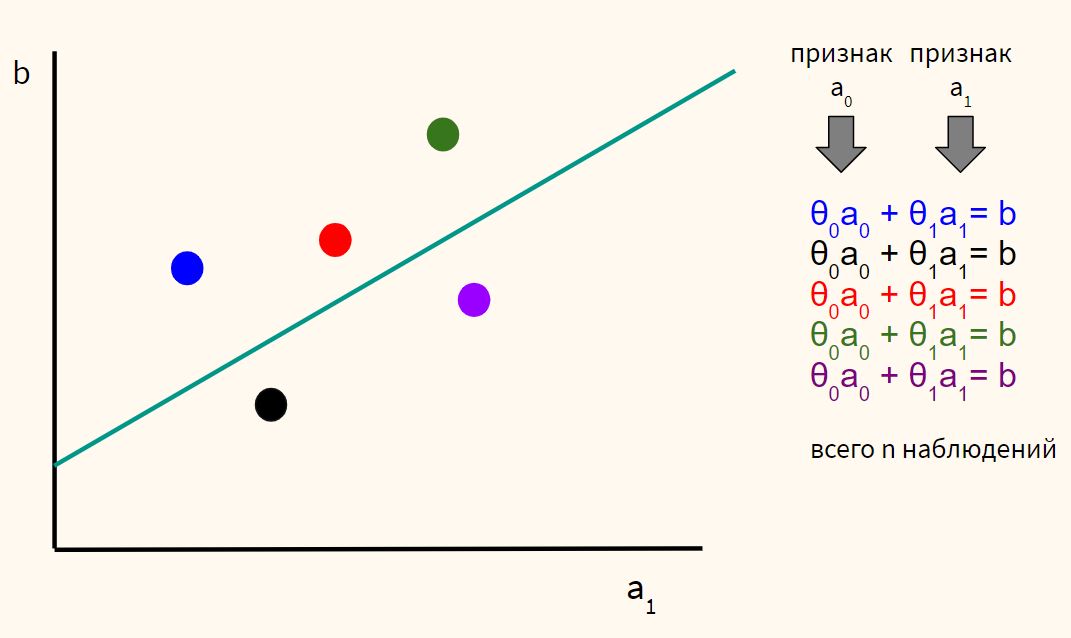

Выше обычная задача простой линейной регрессии с немного измененной нотацией. У нас есть пять наблюдений (для каждого наблюдения есть информация a_0 и a_1, a_0 заполнена единицами). Подставив некоторые веса \theta_0 и \theta_1, мы получим для каждой точки некоторую целевую переменную b (обычно мы её обозначали через y).

Единственного решения для такой системы не существует, то есть мы не сможем подобрать такие \theta_0 и \theta_1, которые бы удовлетворяли всем a_0 и a_1 в каждой строке (для каждого из наблюдений).

Такая система уравнений называется переопределенной (overdetermined). У нас пять уравнений (наблюдений) и при двух неизвестных (коэффициентах). Можно также сказать, что мы наложили слишком много ограничений (ограничения, в данном случае, это уравнения), чтобы найти единственное решение.

Перепишем эту систему с помощью матриц. В общем случае у нас, конечно, может быть больше признаков a_0, a_1, a_2, \dots, a_k, однако систему по-прежнему будем считать переопределенной, то есть n > k. Также заменим \theta на x.

При этом в данном случае A, \mathbf{x} \in \mathbb{R}^k, а \mathbf{b} \in \mathbb{R}^n. То есть вектор \mathbf{b} находится в пространстве большей размерности, чем \mathbf{x}. Например, вектор \mathbf{x} может находиться на плоскости (двумерный вектор), а вектор \mathbf{b} — в трехмерном пространстве.

Можно также сказать, что не существует линейной комбинации значений вектора \mathbf{x} (веса модели) и векторов a_0, a_1, a_2, \dots, a_k, которые преобразовывались бы в вектор \mathbf{b}.

Наконец, справедливо, что \mathbf{b} не находится в пространстве столбцов A, \mathbf{b} \notin \text{col}(A) (то есть не находится на плоскости), а вектор \mathbf{x} как раз лежит на этой плоскости, и это значит, что мы никак не можем перевести с помощью матрицы A вектор \mathbf{x} из двумерного пространства в трехмерное.

С другой стороны, мы можем попробовать получить наилучшее возможное решение, найдя такой вектор \mathbf{x}^*, который будет максимально приближен к вектору \mathbf{b} (т.е. будет иметь минимальное расстояние до него). Расстояние же между векторами можно определить как разницу двух векторов.

Для того чтобы положительные и отрицательные значения не взаимоудалялись, возведем значения в квадрат.

Очевидно, что вектор (назовем его \mathbf{p}), получившийся в результате A \mathbf{x}^*, будет в пространстве \mathbb{R}^k, что то же самое, что \mathbf{p} \in \text{col}(A) (то есть в данном случае на плоскости).

Далее, наименьшее расстояние от вектора \mathbf{b} до \mathbf{p} можно определить как ортогональную проекцию \mathbf{b} на пространство столбцов A.

Попробуем найти решение относительно \mathbf{b}.

Вычтем вектор \mathbf{b} из обеих частей.

Заметим, что вектор \text{proj}_{\text{col}(A)} \mathbf{b} - \mathbf{b} (на рисунке представлен красным вектором) ортогонален к плоскости \text{col}(A). Как следствие, A \mathbf{x}^* - \mathbf{b} ортогонально \text{col}(A).

Можно также сказать, что A \mathbf{x}^* - \mathbf{b} является ортогональным дополнением пространства \text{col}(A). Запишем это как A \mathbf{x}^* - \mathbf{b} = \text{col}(A)^{\perp}.

Одновременно ортогональное дополнение пространства столбцов матрицы A равно ядру A^\top, то есть \text{col}(A)^{\perp} = \text{null}(A^\top). Тогда:

Если умножить матрицу A^\top на её ядро A \mathbf{x}^* - \mathbf{b}, то мы получим нулевой вектор.

Таким образом, можно найти \mathbf{x}^*, которое минимизирует квадрат расстояния между вектором \mathbf{b} и вектором проекции A \mathbf{x}^*.

Уверен, вы узнали в этом выражении нормальные уравнения, о которых мы говорили на занятии по линейной регрессии.

Нормальными же эти уравнения называются, потому что A \mathbf{x}^* - \mathbf{b} \perp \text{col}(A), а нормалью в геометрии как раз считается обобщенное понятие перпендикуляра к поверхности.

Более того, можно сказать, что минимизация расстояний от точек до прямой вдоль оси y одновременно приводит к минимизации длины перпендикуляров к проекциям точек.